NDS #54 - Curso de logs 5/10, el padre de la WWW confirma su colapso, qué es BlockRank, Gemini 3 y Antigravity, el SEO en JavaScript... y más...

Analizamos las novedades semanales del sector SEO e IA y sobre todo cómo nos puede afectar como consultores y te cuento mis vivencias y aprendizajes sentado varias horas al día frente a un monitor.

Me hace mucha ilusión saludarte en esta edición de la newsletter NDS, espero que cumpla tus expectativas y si es así, o si no lo es, estaré encantado de que me des feedback.

¿Quién es Javier Flores y qué es NDS? :)

👨💻 ¡Hola! Soy Javier Flores, consultor SEO en VisibilidadOn y creador de Notas de SEO (NDS), que estás leyendo ahora mismo. Esta newsletter nació en noviembre de 2024 como un espacio para compartir mis aprendizajes en SEO, marketing y negocios digitales. Si te gusta, dime qué opinas. Y si no... ¡también! 😉

🗂️ En el correo de hoy

1️⃣ La viñeta

2️⃣ Actualidad SEO

3️⃣ El proyecto 100% IA y 100% Vibe Coding sigue creciendo

4️⃣ Sitemap XML: la clave para que Google te entienda

5️⃣ Recursos / herramientas

6️⃣ Curso de Logs 5/10 - Crawl Budget: Cómo saber si estás malgastando las visitas de Google

7️⃣ Historia SEO

🎁 Para celebrar los 5 años de VisibilidadOn este mes Josep hará un directo especial de tendencias de SEO para 2026 + sesión de preguntas y respuestas dónde sortearemos 1 año de academia GRATIS.

Fecha: 27/11 a las 17:30

Además, el mismo día activaremos hasta el 30/11/2025 la posibilidad de suscribirte a la academia mediante pago anual de 150€. Ahorrándote 2 meses.

🖌️ La viñeta

Parece que Google Gemini 3 mejora aún más su capacidad de desarrollo de software.

📸 Actualidad SEO

Noticias que lees en un ratillo.

[🛒 Agentic Commerce ya arranca por fin en Google AI Mode] Google ha dado un paso (que muchos esperábamos desde que lo anunciaron) al lanzar el Agentic Commerce en su AI Mode (actualmente solo en EE. UU. y para merchants seleccionados).

Esta funcionalidad permite que la IA actúe como un verdadero asistente personal: puede llamar a tiendas físicas para verificar stock o precios (hace un par de años ya hicieron experimentos con GBP), e incluso realizar una compra autónoma (Agentic checkout) cuando el precio de un producto cae al umbral que el usuario ha preestablecido, todo gestionado a través de Google Pay.

[👾 BlockRank (Blockwise In-context Ranking)] Parece el nombre de un grupo paramilitar que lleva a cabo sus acciones de caza recompensas en la selva, pero no, es un nuevo método de ranking que permitiría a los LLMs llevar a cabo estos sistemas de ranking directamente desde su entrada, te lo explica más a fondo Rafa Villaplana en su perfil.

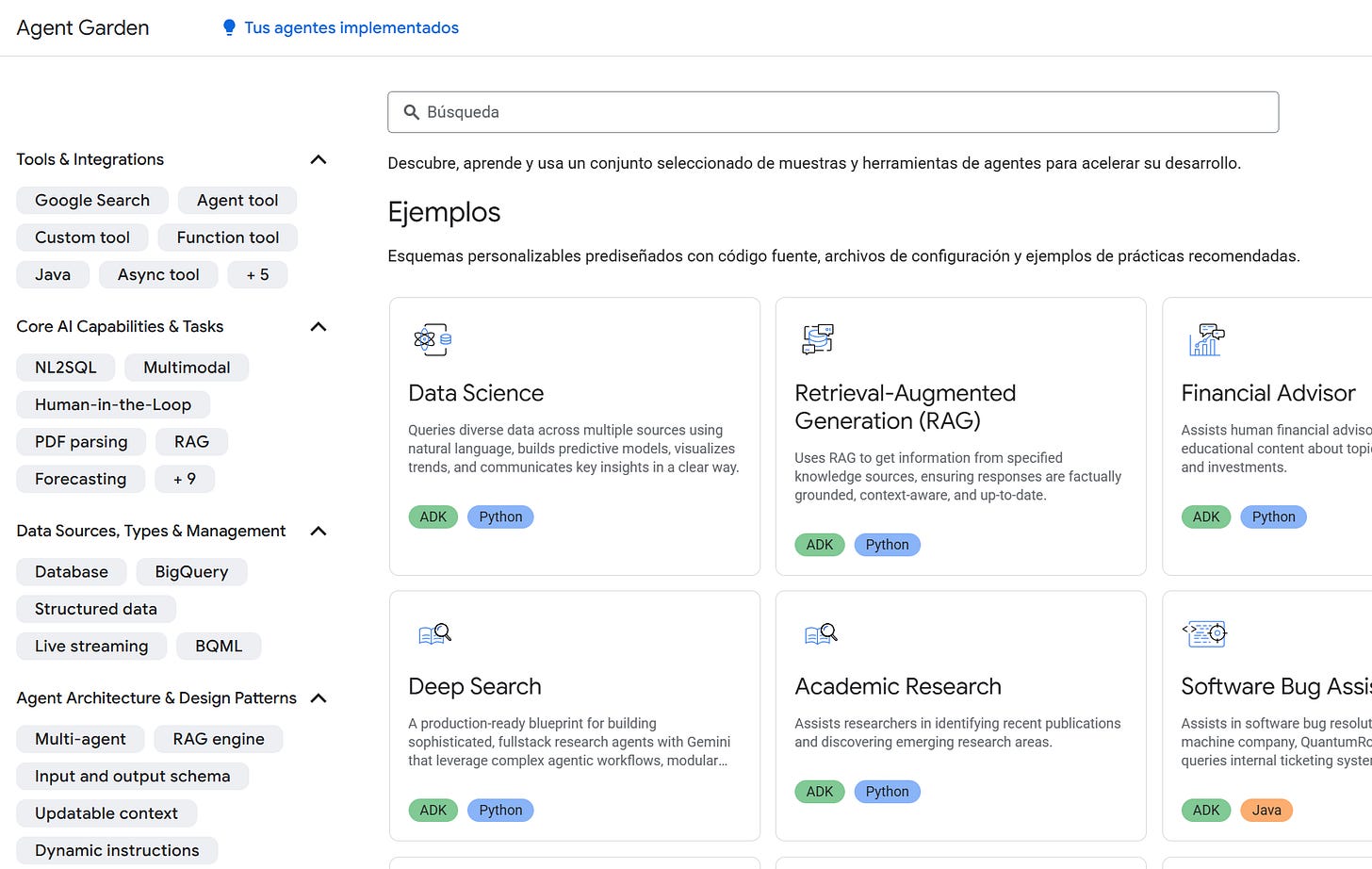

[🤖 Directorio de Agentes IA listos para usar] Google dispone de un directorio de agentes IA para multitud de tareas listos para usar, ya no tendrás que crear un agente para probar alguna idea o llevar a cabo alguna tarea, puedes entrar a Agent Garden, seleccionar el que te interesa y probarlo.

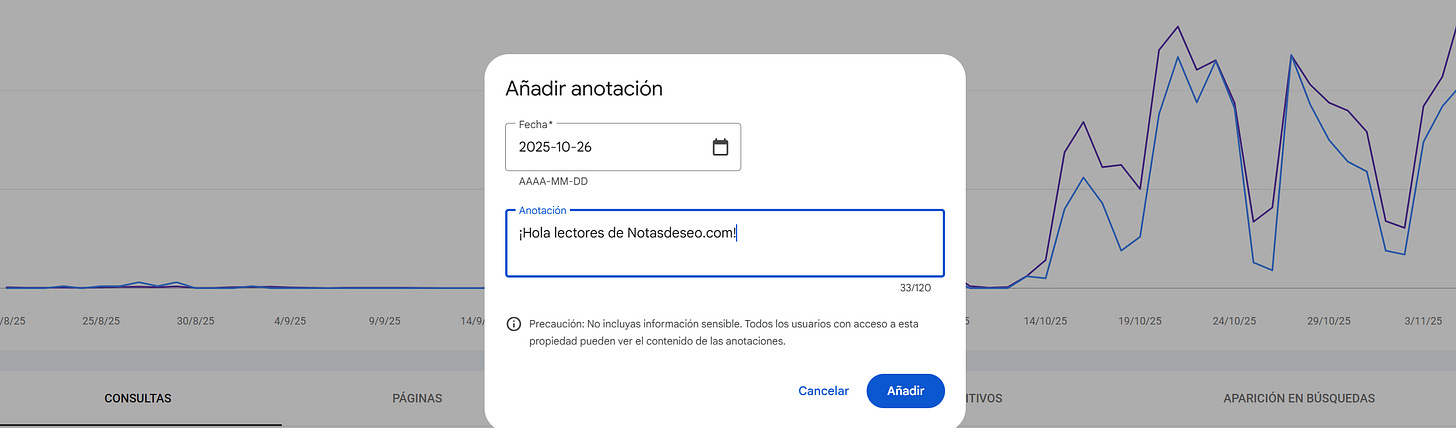

[✏️ ¡Por fin! Llegan las anotaciones personalizadas a los informes de Google Search Console] Esta semana ha “habido movimiento” en las oficinas de Google, han lanzado la funcionalidad de poner anotaciones en las gráficas de GSC, ¡se habrán quedado a gusto después de años esperando!

Además, han presentado otra nueva funcionalidad, que nos permite filtrar querys de marca de querys de no marca, algo que hasta ahora podíamos hacer manualmente, ahorrándonos algo de tiempo en nuestro día a día.

[🤯 El padre de la WWW (Tim Berners Lee) confirma su colapso] Sir Tim Berners-Lee, inventor de la World Wide Web, ha expresado su profunda preocupación por la sostenibilidad de la web actual, basada en la publicidad. Su temor es que si los usuarios dejan de seguir los enlaces y de visitar directamente los sitios web (debido al uso creciente de plataformas de IA), el flujo de ingresos publicitarios desaparecerá, haciendo que todo el modelo de negocio se desmorone.

[🤖 ¡Gemini 3 ha sido lanzado!] Un modelo mejorado, más inteligente, y preparado para la comprensión y generación multimodal compleja. Con una mejor comprensión del lenguaje natural, podrás hacerle tantas solicitudes como necesites. En boca de Sundar Pichai, ¡el mejor modelo del mundo!

[🧰 Cloudflare lanza AI Index] Cloudflare ha lanzado la beta privada de AI Index, una nueva forma de indexar webs optimizada para la Inteligencia Artificial. Su objetivo es crear un ecosistema para la descubribilidad y el uso del contenido, nos lo cuenta más en detalle Natzir Turrado en su timeline de Linkedin.

[🖥️ Antigravity de Google] Sabes que me apasiona el vibe coding, básicamente que los que no somos programadores profesionales podamos desarrollar código de forma más sencilla con la IA, pues bien, Google ha presentado Antigravity, un nuevo IDE impulsado por Gemini 3 Pro (que hemos visto arriba) que revoluciona el desarrollo.

Su principal característica es que permite a los agentes de IA no solo escribir código, sino también planificar, ejecutar, verificar y depurar tareas complejas de forma completamente autónoma. Los agentes tienen acceso directo al editor y al navegador para pruebas (browser-in-the-loop).

Ahora mismo, yo uso Visual Studio + Copilot, y precisamente a veces echo en falta más potencia en esas características que se supone que va a traer Antigravity, así que la semana que viene te contaré que ya lo tengo instalado.. :)

[🎙️ Dominar el SEO en la era de la IA, con Josep Deulofeu] Una muy interesante entrevista en la que Llorenç Palomas (CMO de Doofinder) conversa con Josep sobre cómo dominar el SEO (o al menos sobrevivir) en la era de la IA, muy de acuerdo en lo que se comenta y sí, confirmo que Josep anota en el Calendar cuando se ducha, desayuno, gimnasio, etc, etc… xD

[🎙️ SEO & IA 2026: La guerra de los navegadores agenticos] Arturo Marimon y David Carrasco han declarado el inicio de la “Guerra de los Navegadores Agénticos” con el lanzamiento de ChatGPT Atlas de OpenAI, un navegador con “Modo Agente” y “Memoria” diseñado para actuar en nombre del usuario, a lo que Google y Perplexity ya están respondiendo con nuevas herramientas.

En el Core Update se analizaron las nuevas patentes clave de Google (como BlockRank (que ya vimos más arriba) y Query Groups en GSC (que vimos en una edición anterior de NDS) y la “Entity Update” de ChatGPT, que reduce menciones de marca e indica la creación de una base de datos propia.

El Efecto Lindy pone en duda la amenaza real de la IA al revelar un estudio que solo automatiza el 2,5% de las tareas, aunque Jerome Powell culpa a la IA del freno en la creación de empleo.

Finalmente, el cierre de la plataforma Lorelight subraya que la construcción de marca es la única estrategia sostenible, incluso ante la optimización para la IA.

[📃 The Sitebulb JavaScript SEO Report] Si quieres entender como Google rastrea, renderiza y rastrea JavaScript, siéntate, prepárate un café y disfruta, porque este estudio de Sitebulb con la ayuda de varios profesionales del sector cubre todas las dudas que te puedan surgir, cómo auditar sitios con JS, cómo optimizar el rastreo, cómo lo tratan los LLMs, etc…

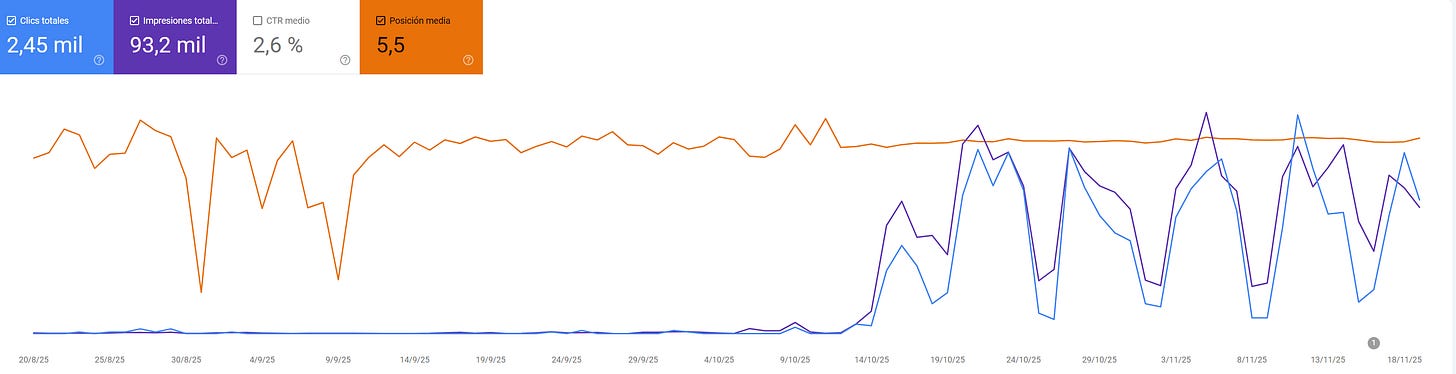

👨🎓El proyecto 100% IA y 100% Vibe Coding sigue creciendo

Ya lo comenté por Linkedin, el proyecto que empecé de prueba hace unas semanas está funcionando “bien”, esta semana he optimizado un poco el rastreo, añadido breadcrumbs, etc.. porque son muchas URLs y de momento no se están indexando todas, a ver si así mejora.

Es un dominio nuevo, quizás con uno expirado hubiera ido bien.

De momento no puedo desvelar el dominio, pero os diré que es un directorio, a día de hoy crear un directorio de cualquier temática es muy sencillo gracias a la IA, tiene gracia que unos 20 años después de trabajar directorios + adsense vuelvo a trastear con ellos.

Dominios como webz.es, minibuscador.com… me sirvieron hace años para ganar dinero con Adsense, de hecho recuerdo que hice incluso una plantilla con PHP para simplemente cambiando la BD poder crear directorios de cualquier temática, enlaces, turismo, medicamentos (el YMYL no estaba ni se le esperaba)..

Este tipo de proyectos nos sirven para entender cómo funciona Google y probar ideas sin poner en riesgo proyectos de clientes.. además, ¡me lo paso pipa! :D

📺 Sitemap XML: la clave para que Google te entienda

Si te interesa este tema y quieres aprender más sobre sitemaps y los básicos de indexación en Google, pásate por la academia porque este mes iré publicando un curso completo.

🧰Herramientas / recursos

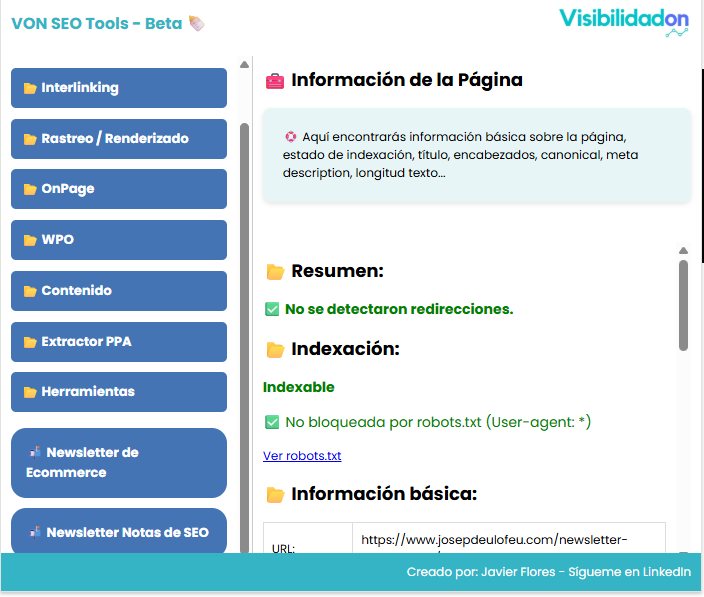

Esta semana he estado añadiendo algunas mejoras y solucionando bugs de la extensión para Chrome de VON SEO Tools, una extensión que en principio desarrollé para uso interno de la agencia pero que al final publicamos y compartimos con todo el mundo, así que si te sirve, ¡genial! :)

Estas son algunas de las tareas que puedes realizar con VON SEO Tools:

Verificador de Robots.txt: Analiza las reglas del archivo para detectar problemas de bloqueo, puedes analizar URLs una a una si quieres..

Detector de HrefLang: Valida y verifica la correcta implementación de etiquetas hreflang.

Validador de datos estructurados: Verifica que la implementación de Schema.org (JSON-LD) sea correcta y/o enlaza a las herramientas oficiales de Schema y Google.

Análisis de Meta Etiquetas: Inspecciona la etiqueta

robotspara asegurar la directiva de indexación.Análisis de Cabeceras HTTP: Revisa cabeceras de seguridad, caché y SEO.

Comparador HTML/DOM: Detecta diferencias entre el código fuente y la versión renderizada, esencial para sitios JavaScript.

Análisis de Imágenes: Identifica problemas como falta del atributo

alt, peso excesivo o necesidad de lazy loading.

Analizador de Encabezados (H1-H6): Verifica la jerarquía y estructura del contenido.

Densidad de Palabras Clave: Identifica términos y frases relevantes, con análisis por secciones.

Extracción de Información Básica: Obtiene Título, meta description, URL canónica, etc.

Interlinking: Detecta enlaces internos/externos, clasificándolos en follow, nofollow y, crucialmente, enlaces rotos (404).

Extractor de PPA (People Also Ask): Una nueva funcionalidad para analizar las SERPs y optimizar el contenido para preguntas.

Y más… :)

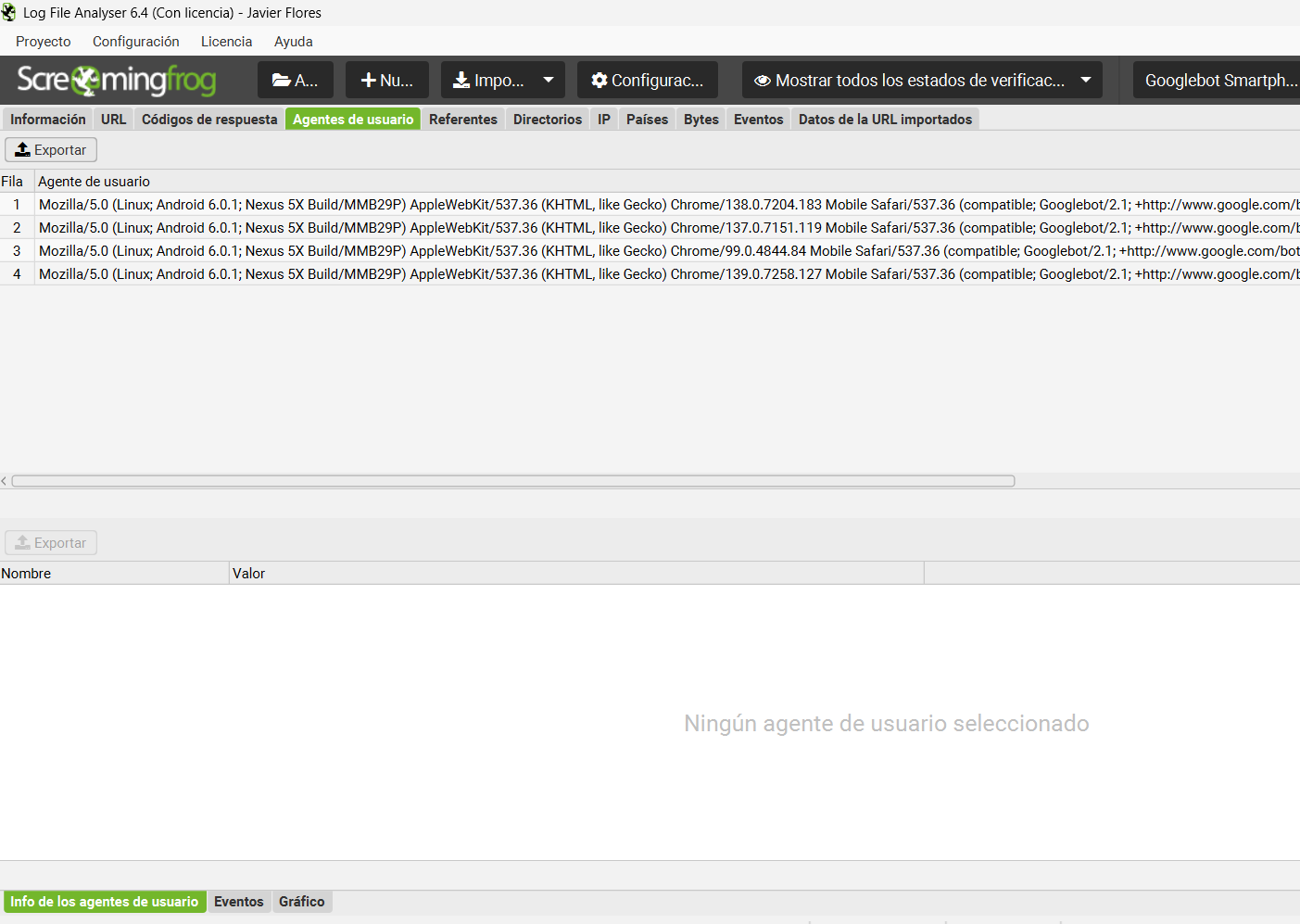

🧑🏻🏫 Curso de Logs 5/10 - Crawl Budget: Cómo saber si estás malgastando las visitas de Google

Hoy hablamos del Crawl Budget o presupuesto de rastreo.

Imagina que Google te asigna un número limitado de “créditos de atención” cada día. Cada vez que Googlebot visita una URL de tu web, gasta un crédito. La pregunta es: ¿estás gastando esos créditos en tus páginas importantes o los estás malgastando?

Los logs son la única forma de medir y optimizar esto con precisión.

Al analizar tus logs, puedes responder a preguntas clave:

¿Cuántas URLs rastrea Google de media al día en mi web?

¿Está perdiendo el tiempo en URLs con parámetros, filtros de búsqueda, o páginas de paginación antiguas?

¿Está rastreando versiones no canónicas o páginas que tienes bloqueadas en

robots.txt?

Identificar este “crawl waste” (desperdicio de rastreo) es una de las optimizaciones técnicas más rentables. Si consigues que Google dedique su tiempo a tus URLs de negocio, tu indexación y posicionamiento mejorarán.

💡 Optimizar tu Crawl Budget tiene un impacto directo en tu indexación y posicionamiento. Conviértete en un experto con el curso completo de Análisis de Logs en la academia de VisibilidadOn.

🏛️El fantasma de la SERP: cuando posicionar era escribir en blanco sobre fondo blanco

Hubo un tiempo, a principios de los 2000 (todavía nos estábamos recuperando de la fiebre del efecto 2000), en que la inteligencia de un motor de búsqueda como Google era bastante simple. Los bots solo sabían una cosa con certeza: cuantas más veces se repite una palabra, más importante es para la página.

Si querías posicionar tu web para “seguros baratos para coche”, la lógica era aplicar la máxima en su forma más brutal. Esto nos llevó a la invención de una práctica que hoy nos provoca escalofríos, pero que entonces era una ventaja competitiva brutal: el keyword stuffing masivo.

El problema era que llenar un texto de 400 palabras con la frase clave repetida 50 veces hacía que la lectura fuera un tormento, algo así: “Somos los mejores seguros baratos para coche, busca tu seguro barato para coche y consigue el seguro barato para coche que necesitas. Consigue ahora tu seguro barato para coche...”

¡Insoportable! xD

🎨 La táctica de la invisibilidad (cretividad al ataque!)

Pero si el contenido era para los ojos del robot y no para los del usuario, ¿por qué no ocultarlo?

Nació la técnica legendaria del texto invisible. Era pura alquimia digital:

Montabas tu contenido de calidad para el usuario.

En la parte inferior de la página, pegabas una lista kilométrica de todas las palabras clave y sus variaciones imaginables.

Aplicabas el truco mágico: Si el color de fondo de la web era, digamos, #FFFFFF (blanco), seleccionabas ese bloque de texto y le cambiabas el color de la fuente a #FFFFFF también.

¡Voilá! El usuario veía una página limpia y funcional, pero el crawler de Google pasaba por allí y leía un manifiesto de palabras clave que gritaba: “¡Soy la página más relevante del mundo sobre este tema!”

¡Ojo! En esta época del GEO ya habrás visto por ahí técnicas similares para “engañar” a los LLMs y obtener más visibilidad, sigue leyendo para saber qué pasó con ésta técnica en Google y cómo puedes acabar si usas cosas similares.. :D

📝 Nota: El texto invisible no solo incluía el blanco sobre blanco. También se usaba texto minúsculo (tamaño de fuente 1px) o mover los bloques de texto fuera del área visible del navegador con CSS.

🥊 La respuesta de Google

Por supuesto, Google no tardó en darse cuenta de que había un fantasma recorriendo sus resultados. La experiencia de usuario era nefasta: la gente hacía clic en resultados que estaban allí por trampas y no por calidad. El algoritmo tenía que madurar.

Fue nuestra primera gran lección sobre la ética SEO.

Google implementó filtros y, más tarde, actualizaciones de algoritmo específicas para detectar patrones de:

Densidad extrema de palabras clave (el famoso Keyword Stuffing).

Contraste de colores nulo entre fondo y texto.

Manipulación de tamaño de fuente o posición de los elementos.

El día que Google penalizó un sitio por esta táctica fue como un meteorito impactando en la Tierra. Los sitios penalizados no solo perdieron su posición, sino que a menudo eran expulsados del índice de forma manual y permanente.

📉 La moral y la ley del SEO moderno

La era de “escribir en blanco sobre fondo blanco” marcó el fin de la inocencia. Nos enseñó a las malas que el juego de las búsquedas iba a ser cada vez más complejo y, sobre todo, más justo.

El legado de esa época es la regla de oro que define al SEO White Hat hoy:

Tu contenido debe estar diseñado para ser consumido por el ser humano que está al otro lado de la pantalla, no para ser escaneado por un robot.

Hoy en la época de los LLMs, GEO… y demás, no está de más recordar esta historia no tan lejana antes de lanzarte a crear una estrategia agresiva y arriesgada para tu proyecto.

Estamos en contacto

Puedes encontrarme en Linkedin, Twitter, mi blog, en mi canal de Youtube o trabajando a diario en la Agencia VisibilidadOn

🤜🤛 Si quieres que escriba sobre un tema concreto, que analice alguna web en vivo, que pruebe alguna herramienta, patrocinar la newsletter o financiarme un viaje en moto por Europa ahora es el momento, ¡contáctame!

📚 Si te has perdido alguna publicación o quieres revisar las anteriores, tienes el archivo disponible online para tí.